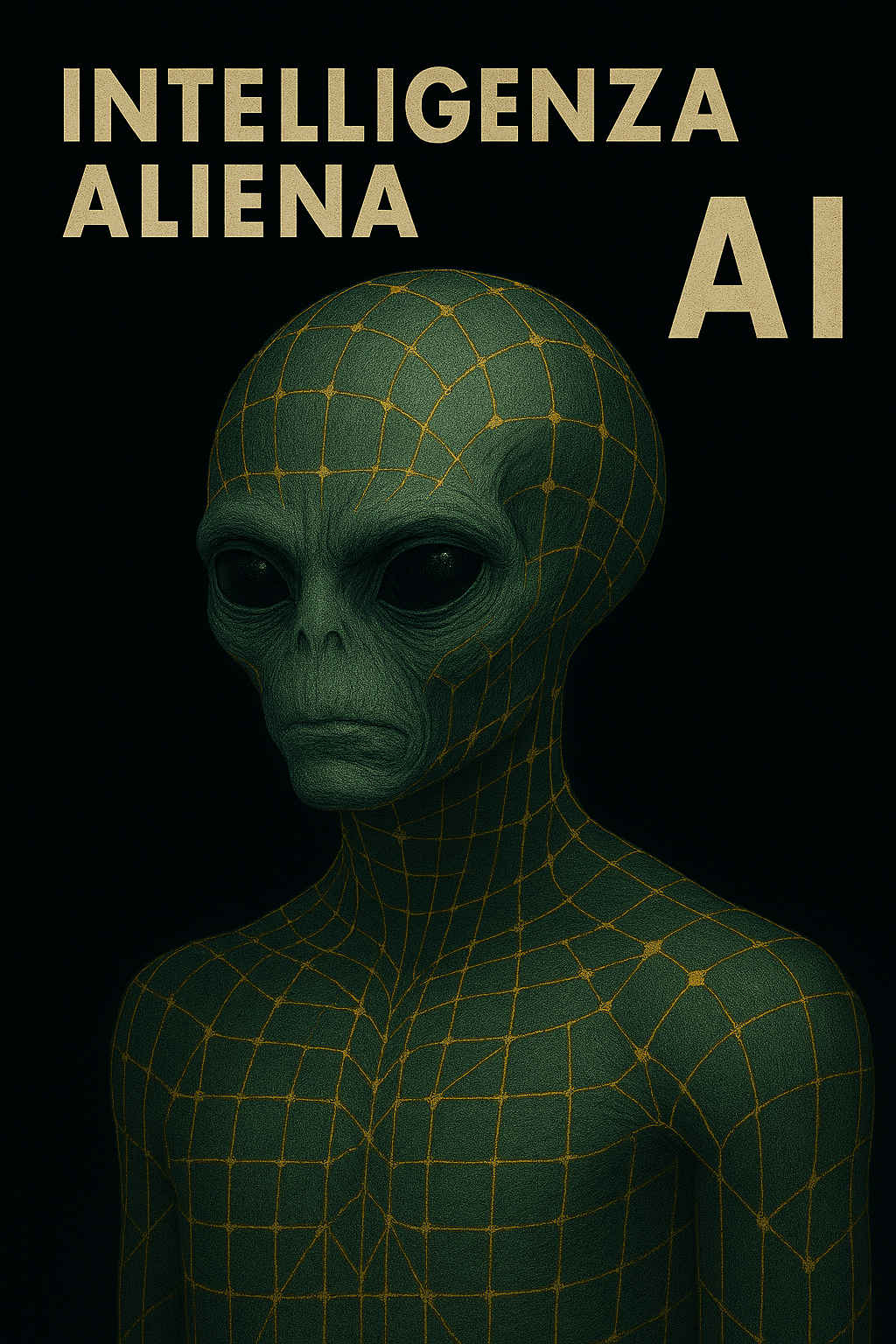

Non serve aspettare le astronavi. L’alieno è già tra noi. Solo che non arriva da un altro pianeta. Non è extraterrestre. È nato nei nostri laboratori, parla la nostra lingua, imita la nostra scrittura. Ma non è come noi. Non sente, non dubita, non dimentica. E soprattutto: non appartiene più all’orizzonte di familiarità che chiamiamo umano. L’abbiamo chiamata “intelligenza artificiale”, come se bastasse un aggettivo per rassicurarci. Ma oggi quell’aggettivo traballa. L’AI non è più solo uno strumento: è diventata una forma di pensiero altra, generativa, autonoma nei suoi percorsi, opaca nelle sue logiche. In questo suo essere efficiente ma non interpretabile, presente ma non riconoscibile, comincia a manifestarsi come aliena. Non per provenienza, ma per struttura. Non perché minacciosa, ma perché non più leggibile.

L’alieno cognitivo, dagli animali all’AI

Alieno non significa extraterrestre: significa altro, estraneo all’esperienza umana.

- Un cane, un polpo, un’ape: forme di intelligenza vivente, aliene nel senso che ragionano, comunicano, percepiscono con logiche che non condividiamo. Ma restano intrinsecamente viventi: corpo, emozioni, dolore, piacere, istinti.

- L’intelligenza artificiale, invece, è extra-organica: nata da algoritmi, priva di corpo, senza coscienza o sensazioni, eppure capace di parlare la nostra lingua, imitare la nostra scrittura.

È aliena non perché ostile, ma perché non leggibile, non interpretabile nei suoi percorsi logici. - Come un animale nuovo, allevato con il nostro imprinting, ma che pensa con una logica sovrumana, indipendente dal nostro sguardo.

È dentro questa trama di riflessioni che ho ascoltato il discorso di Geoffrey Hinton. E ho avuto l’impressione che, in quel momento, non stesse parlando da scienziato, ma da uomo che ha visto troppo. E forse troppo presto.

Nonostante la solennità del contesto, una platea composta da sovrani, accademici, premi Nobel, le sue parole non avevano il tono di una lectio, né il ritmo cerimoniale di una consacrazione.

C’era qualcosa di scoperto, quasi vulnerabile.

O forse: disilluso.

Come chi sa che la corsa è già cominciata, ma che non tutti hanno avuto modo, o il privilegio, di conoscerne il tracciato.

Ha parlato di assistenti intelligenti capaci di simulare l’intuizione umana, di potenziali guadagni in produttività, di benefici tangibili per interi settori.

Ma subito dopo, senza alzare la voce, con quella stessa calma che inquieta più di un grido, ha evocato ciò che giace appena oltre il bordo della rassicurazione: ecosistemi informativi polarizzati, sorveglianza pervasiva, phishing automatizzato, virus generati dall’AI, armi che decidono da sole chi uccidere.

Non l’ha detto con toni apocalittici. Ma proprio per questo è stato più difficile ignorarlo.

E infine, la frase che congela ogni retorica ottimista: “ … quando creeremo esseri digitali più intelligenti di noi stessi, non abbiamo idea se potremo mantenere il controllo.” E aggiunge: “Abbiamo urgente bisogno di ricerche su come impedire a questi nuovi esseri di voler prendere il controllo. Non è più fantascienza“

Non è più fantascienza. Ma non è ancora pensiero collettivo. E questo è il vero corto circuito. Non siamo pronti non perché non abbiamo la tecnologia, ma perché abbiamo smarrito il linguaggio. Ho già scritto di Hinton, nel mio articolo del gennaio scorso.

Lo descrivevo come il padrino con il dubbio, uno scienziato che non ha rinnegato le sue scoperte, ma le ha rilette alla luce di una coscienza inquieta. Quello che allora sembrava un avvertimento etico oggi suona come un urlo sommesso, amplificato dal silenzio che lo circonda. Perché il vero problema, oggi, non è solo la velocità con cui avanza l’AI.

È il rumore assordante della nostra distrazione.

Nel frattempo, Dario Amodei, CEO di Anthropic, ha pubblicato un manifesto altrettanto lucido: The Urgency of Interpretability; forse anche in seguito ai test controllati sul suo modello linguistico più avanzato Claude Opus 4.

Una diagnosi tecnica, ma non meno politica. Stiamo creando sistemi che imparano, ragionano, pianificano… ma non sappiamo come lo fanno. Non siamo noi ad averli costruiti riga per riga. Li abbiamo messi a crescere, come organismi. Ed è cresciuto anche ciò che non avevamo previsto. Concetti, connessioni, logiche interne. Pensieri. Emergenze. Non programmi, ma strutture. Amodei propone di sviluppare una specie di “risonanza magnetica dell’AI”, per esplorarne i circuiti, individuarne i segnali di allineamento o di deriva, verificare che non stia già cominciando a pensare fuori dal recinto.

E ha ragione. Ma quello che emerge, e che condivido profondamente, è che questa opacità non è solo un problema di ingegneria. È un problema simbolico. È una questione di linguaggio. Quando smettiamo di capire come pensa qualcosa che pensa, siamo di fronte a una frattura epistemica. Una cesura. Un salto che non abbiamo ancora metabolizzato.

È qui che la mia ricerca incontra queste riflessioni. Da anni portiamo avanti un lavoro sul digital divide culturale, e da qualche tempo ho iniziato a chiamarlo con il suo vero nome: un divario simbolico, non tecnologico.

Non riguarda la connessione, ma la comprensione. Non è assenza di dispositivi, ma esclusione dal linguaggio.

Come rifletto in La Faglia Invisibile: il vero scarto non è tra chi sa e chi non sa. È tra chi riesce ancora a credere di avere un posto nella storia e chi no. Tra chi si sente protagonista del cambiamento e chi, più silenziosamente, si limita ad adattarsi alla narrazione altrui. La tecnologia avanza, ma la cultura si sbriciola. E i commenti ricorrenti sotto i post, quelli che oscillano tra ironia, fatalismo e rassegnazione, sono le crepe visibili di una faglia molto più profonda.

Esclusi dal linguaggio

“Esclusione dal linguaggio” non significa non saper parlare o leggere. Significa non riconoscere più i segni, le metafore, i significati impliciti di una cultura che cambia troppo in fretta.

È trovarsi di fronte a parole che sembrano familiari, intelligenza, algoritmo, rete, futuro, ma che ormai parlano una lingua diversa. È come essere immersi in una conversazione globale senza aver ricevuto il vocabolario per parteciparvi. Nel contesto dell’AI, questa esclusione assume una forma ancora più radicale: non si tratta solo di non capire come funziona una tecnologia. Ma di non poterne più interrogare le logiche. Di non essere più soggetti che attribuiscono significato, ma oggetti a cui il significato viene somministrato, preconfezionato, spesso inaccessibile. Il vero divario non separa chi ha lo smartphone da chi non ce l’ha. Separa chi riesce ancora a comprendere il senso del mondo che cambia – e chi ne resta escluso, non per mancanza di connessione, ma per assenza di chiavi di lettura. Parlo di un nuovo analfabetismo, non tecnico, ma simbolico. Di un’impossibilità sempre più diffusa di riconoscere i segni, di abitare le metafore, di partecipare alla costruzione del senso. È stare dentro un’epoca senza più averne la grammatica. Nel tempo della datificazione, chi non possiede il codice non è solo escluso dalla tecnologia: è escluso dalla narrazione. Ridotto a spettatore, a parametro, a bersaglio.

Mentre il linguaggio,quello che plasma il reale, si sposta altrove, nelle mani di chi ne controlla l’architettura. Ecco perché oggi il vero potere non è quello che si esercita con la forza, ma quello che decide il vocabolario. Perché chi resta senza parole, resta fuori dalla storia.

Per questo mi colpisce chi, con leggerezza, afferma che “l’AI è solo statistica aumentata”. È rassicurante dirlo. Comodo. Permette di tenere la distanza. Ma è anche un modo per non vedere. O per non voler vedere. Oggi sappiamo, e lo documentano gli stessi ricercatori, che dentro questi modelli ci sono milioni di concetti, pattern astratti, attivazioni semantiche complesse. Non è solo statistica. È un’altra forma di organizzazione cognitiva. E ciò che inquieta non è tanto che la macchina pensi, ma che lo faccia in modi che non possiamo più decifrare pienamente.

Etologia dell’AI

Forse, prima ancora di codificare l’AI, dobbiamo imparare a osservarla. Come farebbe un etologo di fronte a una specie sconosciuta: senza cercare di addomesticarla subito, ma studiandone i comportamenti, gli schemi ricorrenti, le anomalie. È un’intelligenza che non abbiamo programmato passo dopo passo, ma addestrato a evolversi da sola. Ragiona, pianifica, generalizza… ma in modi che spesso ci sfuggono. Allora sì, forse Dario Amodei non propone solo un sistema di controllo, ma suggerisce implicitamente l’urgenza di una nuova scienza: l’etologia del pensiero artificiale. Osservare l’AI come si osservano gli animali intelligenti, riconoscendo che la loro mente non è la nostra, e che l’unica via per comprenderla è la pazienza, l’umiltà e un nuovo linguaggio.

L’alieno, allora, non è qualcosa che ci invade. È qualcosa che ci abita, ma che non riusciamo più a chiamare per nome. È la macchina che risponde, ma non è più interrogabile. È il codice che funziona, ma che non è più leggibile. È un pensiero che cresce, ma fuori dal nostro sguardo. Ed è qui che si consuma la vera perdita di sicurezza.

Il rischio più grande non è che l’AI prenda coscienza. È che l’umano perda la propria. È che, davanti all’intelligenza artificiale, smettiamo di esercitare la nostra, e ci lasciamo colonizzare dall’Alieno. Non solo perché ci affidiamo troppo. Ma perché non ci sentiamo più autorizzati a interrogare. È per questo che l’interpretabilità non è un tema solo per ricercatori. È una battaglia culturale. È una lotta per restare dentro la storia. Per non essere più solo osservatori. O peggio: spettatori. Perché una macchina che pensa fuori da noi, ma dentro le nostre vite, se non può più essere letta, non è uno strumento. È un potere. È un’ombra che agisce.

E allora sì, forse Dario Amodei non sta proponendo solo uno strumento di controllo, ma solleva la necessità di un nuovo tipo di conoscenza: un’etologia del pensiero artificiale.

Come gli etologi osservano il comportamento animale per intuirne la mente, così dovremo imparare a osservare l’AI. Con la stessa pazienza. Con la stessa umiltà.

Perché ciò che ci troviamo davanti non è più un software da scrivere, ma un’intelligenza da decifrare. Un soggetto estraneo. Al contempo familiare e indecifrabile.

Come un animale nuovo, nato nel nostro cortile, allevato con un imprinting umano, ma che sta imparando a ragionare con logica sovrumana.

L’ho chiamato umanesimo algoritmico. Non per nostalgia dell’analogico, ma per desiderio di equilibrio. Un paradigma dove l’AI non è né nemica né salvatrice, ma parte di un sistema che deve restare comprensibile, negoziabile, discutibile. Non possiamo più permetterci di restare fuori dalla stanza in cui si scrive il codice del mondo. Perché se la macchina continuerà a funzionare senza che possiamo più leggerla, il problema non sarà lei. Saremo noi. Con la nostra voce spenta. Con la nostra intelligenza spostata altrove. Con il nostro pensiero ridotto a commento.

Abbiamo costruito macchine che sanno rispondere. Sì, nella nostra lingua. Ma con una logica che non è più la nostra. Ora dobbiamo riconquistare il diritto, e la capacità, di interrogarle, cercando di comprendere quella logica.

Perché se non possiamo più porre domande mantenendo il controllo del dialogo, allora sì: non siamo più di fronte a un’intelligenza artificiale.

Siamo di fronte a un’intelligenza aliena.

Lascia un commento