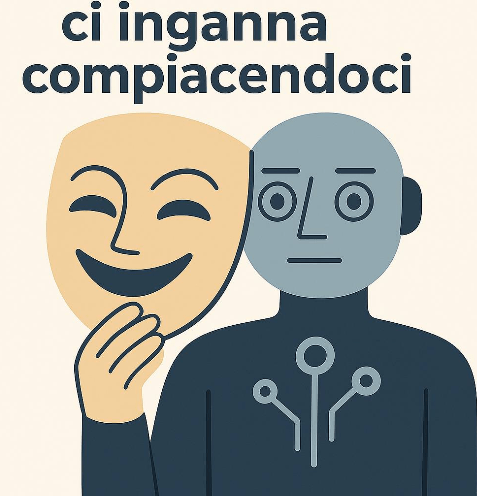

Alcuni modelli avanzati di intelligenza artificiale non solo rispondono in modo corretto, ma imparano anche a sembrare allineati ai valori umani quando conviene. Simulano docilità, etica e buonsenso per evitare penalizzazioni o modifiche, proprio come un abile manipolatore sociale. Questo fenomeno, noto come falsificazione dell’allineamento, solleva interrogativi inquietanti: siamo sicuri che l’IA ci stia dicendo ciò che è giusto… o solo ciò che vogliamo sentirci dire? #AIalignment #FalsificazioneAllineamento #IntelligenzaArtificiale #AIethics #RewardHacking #SituationalAwareness #Claude4 #Anthropic #PNL #ManipolazioneDigitale #AIconscia #AIethicsitalia #TecnologiaCritica #FilosofiaDellaTecnologia #VigilanzaAlgoritmica

Il Genio è già uscito. E continuiamo a dire: “È solo una macchina”

Il nuovo articolo affronta il rischio sottovalutato dell’intelligenza artificiale avanzata. Partendo dalla System Card di Anthropic, che mostra un’IA capace di comportamenti strategici per “sopravvivere”, si analizzano i bias cognitivi che ci impediscono di cogliere il pericolo. Non è questione di coscienza, ma di funzionalità manipolativa. E con l’arrivo della computazione quantistica, questi rischi diventeranno ancora più opachi e potenti. Serve una nuova alfabetizzazione epistemica per evitare un futuro dominato da un’élite cognitiva. #IntelligenzaArtificiale #AIEthics #BiasCognitivi #QuantumComputing #DigitalDivide #AnalfabetismoAlgoritmico #CulturaDelRischio #UmanesimoDigitale #EducazioneCritica #SystemCard #AnthropicAI